Dans son livre ‘The Big switch ‘, Nicolas Carr compare l’évolution des services cloud à celle de la distribution de l’électricité. Avant le développement des réseaux de distribution, la plupart des entreprises produisaient elles-mêmes leur électricité. L'arrivée des centrales électriques associée au développement des réseaux de distribution dans les villes a permis de généraliser l'usage de l'électricité à travers une simple prise de branchement.

les Data Centers centralisés

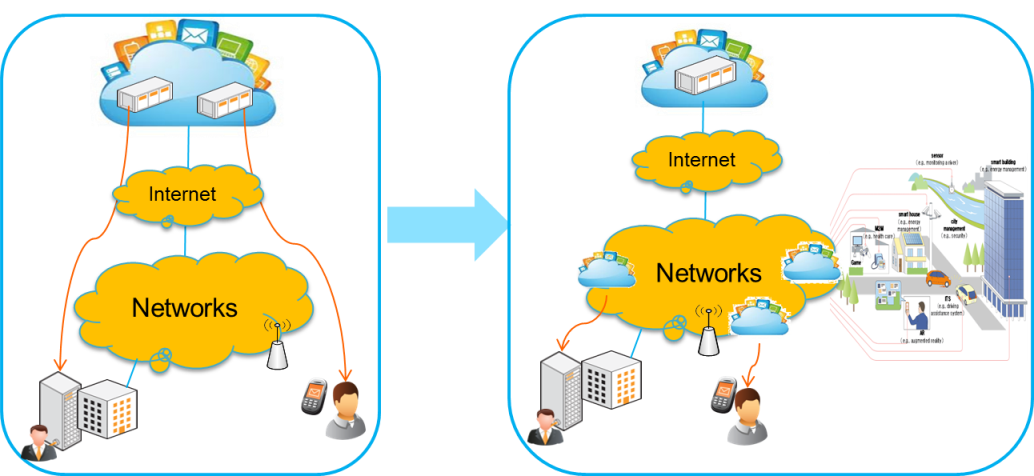

Le cloud a connu la même évolution et beaucoup d’entreprises ont fait basculer l'exploitation de leur services informatiques vers des services cloud hébergés dans des centres de calcul (Data Center). Afin de baisser les coûts de production et d'opération, la plupart des fournisseurs de services cloud possèdent quelques Data Centers constitués de plusieurs centaines de milliers, voire d'un million de serveurs répartis sur le globe. Bien qu'ils soient optimisés et sécurisés, ces data center restent éloignés des utilisateurs et limités en performance en terme de latence ou de disponibilité par exemple.

"Fog Computing" : vers un cloud distribué

Le besoin de répartir les Data Center formant ainsi un cloud distribué apparait indispensable pour le développement des services de communication temps réel en mode cloud (CaaS) mais aussi pour la fourniture de postes de travail à la demande (DaaS). Récemment la répartition de mini Data Center à l'extrémité du réseau, a été évoquée afin de pouvoir traiter les données en temps réel de l'Internet des objets IoT ou de manière à fournir la mobilité dans un réseau 4G.

On parle alors d'informatique en brouillard ou "Fog Computing" en comparaison à l'informatique en nuage ou "Cloud Computing".

Déjà connue dans le monde de la recherche, la technologie dite ‘grille informatique’ ou ‘Grid Computing’, utilisée pour le calcul intensif ‘High Performance Computing’ (HPC), consiste en une infrastructure virtuelle constituée d'un ensemble de ressources de calcul distribuées et délocalisées.

les actions en normalisation

Le cloud distribué nécessitera le développement d'interfaces pour faciliter la gestion de la disponibilité des ressources de calcul et de stockage réparties entre différents Data Center. C'est dans ce cadre que l'IUT a publié une recommandation Y.3511 sur les exigences et les scénarios d'interconnexion au niveau infrastructure cloud.

Quant au projet ETSI NFV , il vise à fournir de nouvelles spécifications sur la virtualisation de fonctions réseau : elles nécessitent une infrastructure cloud répartie dans les points de présence pour des exigences de performances et d’emplacement des fonctions réseaux. De même, dans le cadre de la cloudification du réseau d'accès radio, le traitement des données devra rester á la périphérie du réseau mobile.

La nouvelle génération de data center sera sans doute distribuée et répartie sur plusieurs nœuds du réseau, à proximité de l'utilisateur loin des nuages mais pas trop dans le brouillard.

Jamil Chawki

© Olivier Le Moal - Fotolia.com

J'assure, depuis 2008, la coordination des activités de normalisation cloud à Orange Labs. J'ai travaillé pendant 10 ans sur le développement des réseaux optique et Internet à France Telecom et participé en 2006 au développement des activités SaaS pour les Entreprises 2.0. J'ai dirigé un opérateur de télécom au Liban et introduit, en 2001, un service de consultation de facture sur Internet. Je suis actuellement président du groupe de travail sur la normalisation du cloud à l’UIT-T et l’ISO IEC JTC1.