| La MediaTIC News est une newsletter bimensuelle composée des meilleurs articles des blogs Orange Business : si vous souhaitez recevoir par email, le meilleur de nos articles, infographies etc.. Abonnez-vous à la newsletter ici, c’est gratuit ! |

Laurent Finck dirige chez VMware une équipe de consultants en stratégie informatique pour l’Europe du Sud, dont le rôle consiste à travailler avec les directions informatiques de nos plus grands clients, et à expliquer et envisager avec ces DSI les meilleures manières de transformer leur informatique vers une IT as a service.

Son équipe et lui travaillent avec des entreprises qui ont des budgets de l'ordre de 100 à 150 millions d'euros, donc de tailles très conséquentes.

J’ai interviewé Laurent il y a quelques jours afin qu’il puisse expliquer les tenants et aboutissants de cet important concept et pourquoi il est la préfiguration, dès aujourd’hui, du cloud computing de demain.

Cette interview a été divisée en 2 parties :

- la 1ère partie décrit le concept du Software-Defined Data Center et les grandes étapes de cette transformation

- la 2ème partie aborde la question des sources d'économies possibles et l'évolution du rôle du DSI attachées au SDDC

Le concept de Software-Defined Data center (le Data center piloté par le logiciel)

D'abord, pour vous expliquer pourquoi nous l’avons mis sur le marché. Ensuite, je voudrais vous expliquer comment on peut envisager la transformation d'une solution d'informatique d'aujourd'hui vers un Software-Defined Data center et quelles sont les grandes étapes de cette transformation.

Et enfin vous décrire ce marché. Où il en est chez les clients pour en déduire les bénéfices économiques tangibles et les contraintes qu'on peut associer à ces transformations importantes.

Pourquoi le SDDC ?

Alors pourquoi nous intéressons-nous à cette solution ?

Aujourd'hui, toutes les DSI sont soumises à une pression de plus en plus importante sur les coûts et sur la qualité. On leur demande d'ailleurs beaucoup plus d'agilité, et même de tout faire à la fois : « réduisez-moi les coups ! », « réalisez-moi une production de qualité ! », « rendez-moi les services les plus agiles et les plus rapides pour mon métier ! ».

Tout cela se traduit par un ensemble de contraintes que les DSI commencent à avoir du mal à concilier. VMware répond à ces contraintes par une solution d'automatisation la plus complète possible de l'ensemble de la production. Et c'est ce que l'on appelle le Software-Defined Data center.

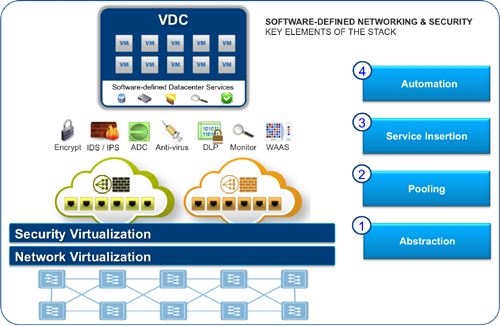

le software-defined data center, illustration VMware

Je parle d'automatisation, mais en gros, c'est de la virtualisation de tous les éléments du Data center qu’il s’agit, non seulement les serveurs, mais aussi le réseau et le stockage. Ce sont les trois grandes briques qui forment les data centers. C'est ce qu’on appelle le « pooling » (c’est-à-dire, la mise en commun, le rassemblement des ressources).

Avec cette automatisation, comme tout est virtualisé et rassemblé au même endroit, on va pouvoir introduire des couches d'automatisation qui vont gérer, sans intervention humaine, tous ces éléments. C'est ça le concept du Software-Defined Data center : virtualisation, rassemblement et automatisation. C'est une destination dans un voyage, un voyage vers le cloud computing.

Si l’on regarde au-delà de l’aspect technique, le Software-Defined Data center, par cette capacité à tout abstraire, est la brique essentielle à la mise en œuvre d'un cloud hybride. Cette couche d’abstraction est ce qui permettra de choisir entre une exécution locale sur un cloud privé ou une exécution déportée sur un cloud public.

Dans cette situation, on pourra combiner les exécutions sur les plateformes privées et publiques, c'est ce que l'on appelle le cloud hybride. Le Software-Defined Data center est une clé essentielle à la mise en œuvre du cloud hybride, et c'est le cloud hybride qui va porter les économies attendues par le cloud computing.

3 étapes vers l’IT as a service

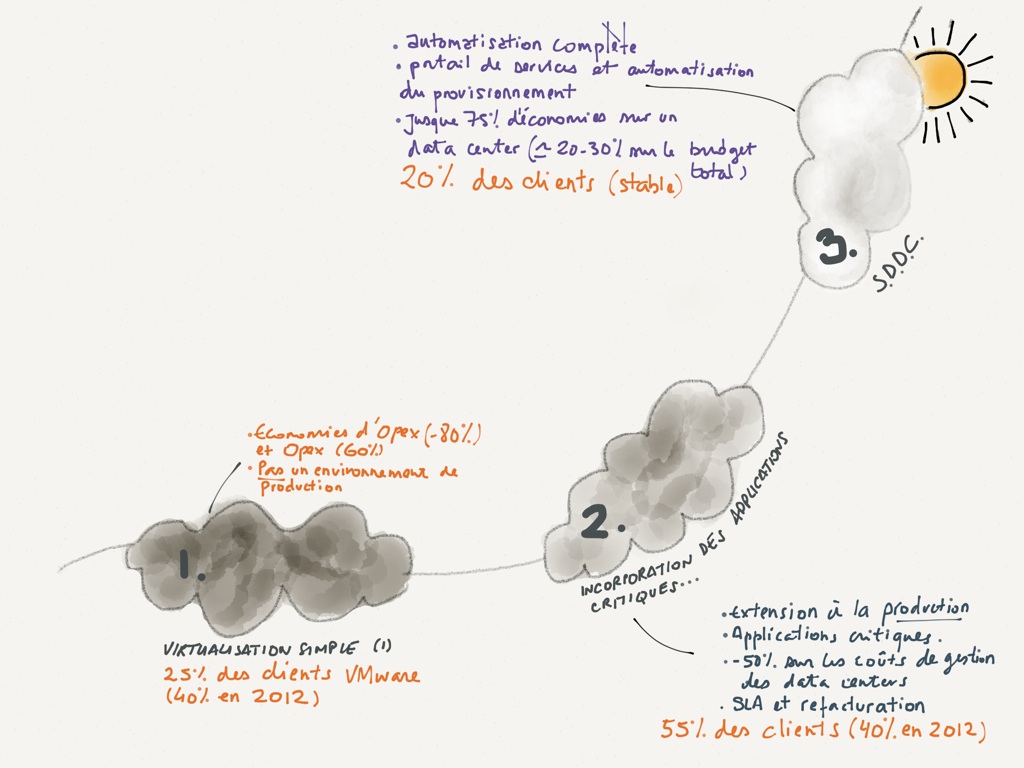

Cette brique essentielle dans ce voyage vers le cloud computing est abordée au travers de trois étapes essentielles :

1ère étape : la virtualisation

D'abord, l'étape de virtualisation dont on a parlé, où je virtualise tous les serveurs, et je fais des économies drastiques d’investissement, puisque les taux de virtualisation d'aujourd'hui permettent bon an mal an de rassembler sur 1 serveur physique l'équivalent de 10 à 15 serveurs physiques d'avant, donc vous imaginez les économies d'investissements qui sont formidables. Cette première étape qui consiste à tout virtualiser génère des économies de l’ordre de 80 % sur le Capex et 60 % sur l’Opex.

On va avoir ensuite toutes les économies d'électricité, de surface, de coûts de Data center qui sont associés à cette actualisation. Mais à ce stade, en reste quand même sur des environnements qui ne sont pas encore des environnements de production.La deuxième étape consiste justement à étendre la virtualisation à des environnements de production où on virtualise des serveurs sur lesquels des applications critiques sont exécutées.

Aujourd'hui, il n'y a plus aucun obstacle à la virtualisation de l'ensemble des serveurs sur lesquels tournent des applications critiques. Il y a encore deux ou trois ans, il y avait quelques clients qui avaient encore peur et qui étaient réticents à poursuivre ce chemin sur les applications critiques. Aujourd'hui, il y a kyrielle d'exemples pour lesquels les clients font tourner leur SAP d’entreprise sur des serveurs dédiés virtualisés. Et VMware a établi des relations avec tous les grands acteurs comme SAP, qui a certifié nos solutions ; il n'y a plus aucun obstacle à cette deuxième étape.

2ème étape : les applications critiques

Dans ce cas, les économies sont moins de l'ordre du Capex de l'investissement de l'ordre des économies d'opérations. En général, on s'attend à une réduction de l'ordre de 50 % sur les coûts de gestion des data center. Donc cela dépend de combien chaque client a dépensé dans ces coûts de gestion et dans les ressources humaines mises à disposition sur les data center. L'ordre de grandeur de 50 % est ce que l'on observe en moyenne.

À ce stade, on a virtualisé les serveurs, on a mis en place des outils de gestion des serveurs virtuels et également des outils de mesure de la capacité. Puisqu’on parle d'applications critiques, on parle aussi de niveau services et de coups de facturation, donc il va falloir mettre en œuvre des outils qui permettent de gérer cette facturation sur la base d'un usage.

3ème étape : l’automatisation complète

La troisième étape c'est enfin l'automatisation complète du data center et de cet ensemble.

L'automatisation complète étant finalement la mise en place d'un portail de services assurant l’automatisation du processus de provisionnement des ressources quand les utilisateurs se connectent à ce portail est consomment des ressources informatiques.

Dans ce cas on met en œuvre des sources d'automatisation de provisionnement et de déprovisionnement, car sinon le data center gonfle sans jamais rétrécir. D'où l'intérêt des solutions de facturation et de mesure de la consommation. On ne peut pas envisager une IT as a service sans avoir une contrainte qui consiste à faire payer à l'utilisateur ce qu'il consomme.

Dans cette situation, le consommateur d'infrastructure va sur son portail et commande. Le Software-Defined Data center va gérer totalement et automatiquement le provisionnement de ces machines, le stockage pour lui fournir le service qu'il souhaite et le niveau de service qu'il est prêt à payer.

Ce concept vous permet de choisir l'endroit où ce provisionnement va être réalisé

Est-ce que c'est dans un cloud public ou privé ? A quel prix ? L’utilisateur va pouvoir accéder aux différentes offres et choisir en fonction des différents niveaux de service et du prix qu’il est prêt à payer. Il clique et sa commande est provisionnée dans l’ordre de la demi-heure. La montée en charge du côté administrateur se fait, quant à elle, tout automatiquement. Le data center est géré par un logiciel.

Yann Gourvennec

Lire la 2ème partie, elle aborde la question des sources d'économies possibles attachées au SDDC et l'évolution du rôle du DSI.

Crédit photo : © alphaspirit - Fotolia.com

Je suis spécialiste en systèmes d'information, marketing de la highTech et Web marketing. Je suis auteur et contributeur de nombreux ouvrages et Directeur Général de Visionary Marketing. A ce titre, je contribue régulièrement sur ce blog pour le compte d'Orange Business sur les sujets du cloud computing et du stockage dans le cloud.